Python 大數據專案 X 工程 X 產品 資料工程師的升級攻略, 3/e

林子軒 著

- 出版商: 深智

- 出版日期: 2026-02-19

- 定價: $880

- 售價: 7.9 折 $695

- 語言: 繁體中文

- 頁數: 656

- ISBN: 6267757803

- ISBN-13: 9786267757802

-

相關分類:

大數據 Big-data

尚未上市,歡迎預購

買這商品的人也買了...

-

$611嵌入式 Linux 基礎教程, 2/e (Embedded Linux Primer: A Practical Real-World Approach, 2/e)

$611嵌入式 Linux 基礎教程, 2/e (Embedded Linux Primer: A Practical Real-World Approach, 2/e) -

$453機器學習中的數學修煉

$453機器學習中的數學修煉 -

$601微服務架構深度解析:原理、實踐與進階

$601微服務架構深度解析:原理、實踐與進階 -

貝葉斯統計導論

貝葉斯統計導論$539$512 -

Raspberry Pi 樹莓派:12道開胃菜打造 Linux 核心肌群(iT邦幫忙鐵人賽系列書)

Raspberry Pi 樹莓派:12道開胃菜打造 Linux 核心肌群(iT邦幫忙鐵人賽系列書)$680$530 -

$764演化學習 理論與算法進展 精裝版

$764演化學習 理論與算法進展 精裝版 -

每個程式設計師都應該要知道的50個演算法

每個程式設計師都應該要知道的50個演算法$690$538 -

流程架構|整合串流與事件驅動的未來 (Flow Architectures: The Future of Streaming and Event-Driven Integration)

流程架構|整合串流與事件驅動的未來 (Flow Architectures: The Future of Streaming and Event-Driven Integration)$580$458 -

AI 必須!從做中學貝氏統計 – 從事機器學習、深度學習、資料科學、大數據分析一定要懂的統計利器 (Bayesian Statistics for Beginners: A Step-By-Step Approach)

AI 必須!從做中學貝氏統計 – 從事機器學習、深度學習、資料科學、大數據分析一定要懂的統計利器 (Bayesian Statistics for Beginners: A Step-By-Step Approach)$1,200$948 -

$703工業大數據分析

$703工業大數據分析 -

AI + IoT 佈建邊緣運算 - 電腦視覺業界專案原理及實作

AI + IoT 佈建邊緣運算 - 電腦視覺業界專案原理及實作$980$774 -

小型網路資訊安全|給網管人員的正經指南 (Cybersecurity for Small Networks)

小型網路資訊安全|給網管人員的正經指南 (Cybersecurity for Small Networks)$520$410 -

Clean Architecture 實作篇:在整潔的架構上弄髒你的手 (第二版) (Get Your Hands Dirty on Clean Architecture, 2/e)

Clean Architecture 實作篇:在整潔的架構上弄髒你的手 (第二版) (Get Your Hands Dirty on Clean Architecture, 2/e)$600$468 -

團隊自省指南|打造敏捷團隊

團隊自省指南|打造敏捷團隊$500$395 -

程式設計守則|如何寫出更好的程式碼 (The Rules of Programming: How to Write Better Code)

程式設計守則|如何寫出更好的程式碼 (The Rules of Programming: How to Write Better Code)$620$489 -

寫程式前的必學工具:命令列、編輯器、Git/GitHub,軟體開發三本柱一次搞定

寫程式前的必學工具:命令列、編輯器、Git/GitHub,軟體開發三本柱一次搞定$490$416 -

$708PyTorch 深度學習指南 捲III :序列與自然語言處理

$708PyTorch 深度學習指南 捲III :序列與自然語言處理 -

這樣寫 code 好不好?辨識、分析、改善,寫出易讀易維護的程式碼

這樣寫 code 好不好?辨識、分析、改善,寫出易讀易維護的程式碼$630$497 -

無瑕的程式碼 軟體工匠篇:程式設計師必須做到的紀律、標準與倫理 (Clean Craftsmanship: Disciplines, Standards, and Ethics)

無瑕的程式碼 軟體工匠篇:程式設計師必須做到的紀律、標準與倫理 (Clean Craftsmanship: Disciplines, Standards, and Ethics)$720$561 -

$453ThinkPHP 8 高效構建 Web 應用

$453ThinkPHP 8 高效構建 Web 應用 -

Clean Code:Python 寫乾淨程式碼 - 告別技術債,不再為爛程式加班收爛攤

Clean Code:Python 寫乾淨程式碼 - 告別技術債,不再為爛程式加班收爛攤$720$568 -

綠色軟體開發|永續軟體開發與營運的方法 (Building Green Software: A Sustainable Approach to Software Development and Operations)

綠色軟體開發|永續軟體開發與營運的方法 (Building Green Software: A Sustainable Approach to Software Development and Operations)$580$458 -

內行人才知道的生成式 AI 系統設計面試指南 (Generative AI System Design Interview)

內行人才知道的生成式 AI 系統設計面試指南 (Generative AI System Design Interview)$750$592 -

我阿嬤都比你會測試:從生活智慧建立測試思維,到自動化與 AI 的完整進化(iThome鐵人賽系列書)

我阿嬤都比你會測試:從生活智慧建立測試思維,到自動化與 AI 的完整進化(iThome鐵人賽系列書)$620$483 -

駭客的 Linux 基礎入門必修課, 2/e (Linux Basics for Hackers : Getting Started with Networking, Scripting, and Security in Kali, 2/e)

駭客的 Linux 基礎入門必修課, 2/e (Linux Basics for Hackers : Getting Started with Networking, Scripting, and Security in Kali, 2/e)$520$410

相關主題

商品描述

【本書特色】

分享在 Github 獲得 2,300 stars 的大數據 Side Project——FinMind,並一步步帶領讀者從 0 開始,打造專屬於自己的大數據 Side Project。

不同於僅止於教學示範的 Side Project,FinMind 是少數經過實際使用者驗證、長期維運的資料服務,完整呈現資料工程從架構設計、系統實作,到產品化與穩定營運的全流程。讀者不只學會「怎麼做」,更能理解 為什麼要這樣做。

【你將學到】

資料工程實戰

►使用分散式架構蒐集證交所、櫃買中心、期交所等股市資料,

►並以容器化技術建構爬蟲、API、資料庫與訊息佇列服務。

低成本雲端部署

►單月約 5 美金 即可運行完整系統,

►一站式管理多台分散式機器與服務。

產品化與迭代流程

►從單元測試、CI/CD 到 API 上線,

►建立可持續維護與擴充的資料產品。

監控與視覺化

►建立專屬資料儀表板,並以業界主流監控工具掌握系統狀態。

作者簡介

林子軒(Sam Lin)

現任 17LIVE Data Engineer Manager,專注於資料工程與資料分析領域。

長期投入 Python 與大數據相關技術實務,並致力於將複雜的資料系統,

轉化為可落地、可維運的實際產品,期望為資料工程社群與開發者提供實用且可複製的經驗分享。

經歷

● 17 LIVE Data Engineer Manager。

● 曾任職永豐金證券,軟體工程師。

● 曾任職 Tripresso,資料工程師。

● 曾於 Open UP Summit 2019、WebConf 2025,擔任 Speaker。

● 東華研究所,應用數學碩士。

FinMind

● https://github.com/FinMind/FinMind

● https://finmindtrade.com/

個人 GitHub

● https://github.com/linsamtw

● samlin266118@gmail.com

如對本書有疑問,歡迎寄信到以上信箱。

目錄大綱

▍第1 篇 資料工程ETL

►01 本書介紹

►02 開發環境

2.1 開發環境重要性

2.2 Linux 作業系統

2.3 Windows 作業系統

2.4 Mac 作業系統

2.5 Python 開發工具VS Code

►03 Docker

3.1 為什麼先介紹 Docker ?

3.2 什麼是 Docker ?

3.3 安裝 Docker

3.4 安裝 Docker Compose

►04 雲端

4.1 為什麼要用雲端?

►05 資料收集

5.1 Python 環境設置

5.1.1 為什麼需要設置環境?

5.1.2 Python 環境、套件管理工具 --- pipenv

5.1.3 Python 環境、套件管理工具 --- uv

5.2 爬蟲

5.2.1 什麼是爬蟲?

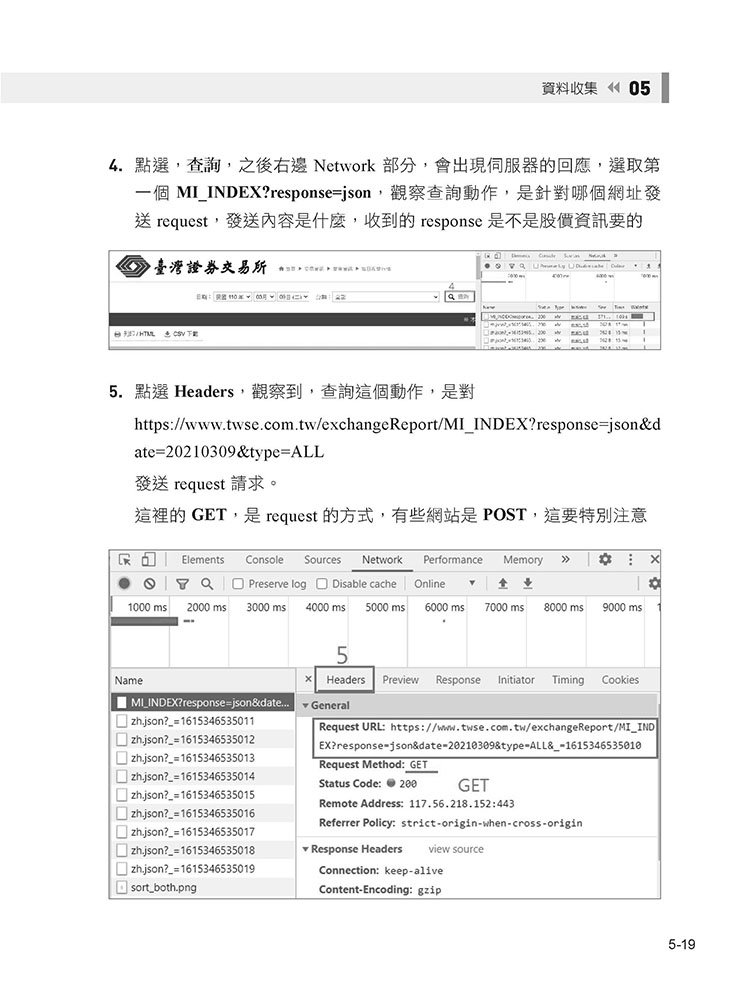

5.2.2 證交所爬蟲範例

5.2.3 櫃買中心爬蟲範例

5.2.4 期交所爬蟲範例

5.3 資料庫架設

5.3.1 什麼是資料庫?

5.3.2 關聯式資料庫 --- MySQL

5.4 上傳資料到資料庫

5.4.1 架構介紹

5.4.2 Clients、Router 資料庫操作

5.4.3 建立 table

5.4.4 爬蟲上傳資料庫

5.5 分散式爬蟲

5.5.1 為什麼需要分散式?

5.5.2 分散式任務轉發 --- RabbitMQ

5.5.3 Python 分散式爬蟲工具 --- Celery

5.5.4 真實應用場景

5.5.5 FinMind 分散式爬蟲架構

5.6 定時爬蟲

5.6.1 為什麼需要定時爬蟲?

5.6.2 APScheduler

5.6.3 APScheduler & 分散式爬蟲架構

►06 資料提供 - RESTful API 設計

6.1 什麼是 API ?

6.2 輕量 API --- Flask

6.2.1 建立第一個 API

6.3 高效能 API --- FastAPI

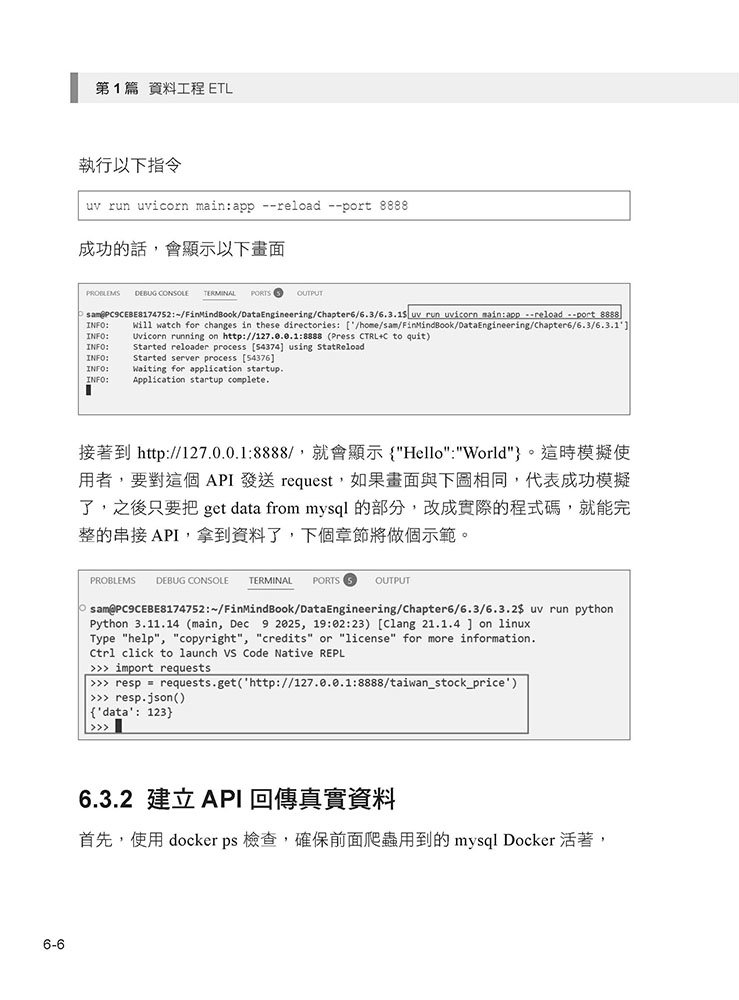

6.3.1 建立第一個 API

6.3.2 建立 API 回傳真實資料

6.3.3 ApacheBench 壓力測試

6.3.4 API 介面 --- Swagger

►07 容器管理工具 Docker

7.1 為什麼要用 Docker

7.2 建立第一個 Docker Image --- Dockerfile

7.2.1 爬蟲

7.2.2 API

7.3 發布 Docker Image

7.3.1 Docker Hub 介紹

7.3.2 發布 Docker Image

7.4 雲端部署

7.5 Docker Swarm

7.5.1 介紹

7.5.2 建立第一個 Swarm

7.5.3 管理介面 --- Portainer

7.6 佈署服務

7.6.1 MySQL

7.6.2 RabbitMQ

7.6.3 爬蟲

7.6.4 API

▍第2 篇 產品迭代 --- 測試運維

►08 自動化測試

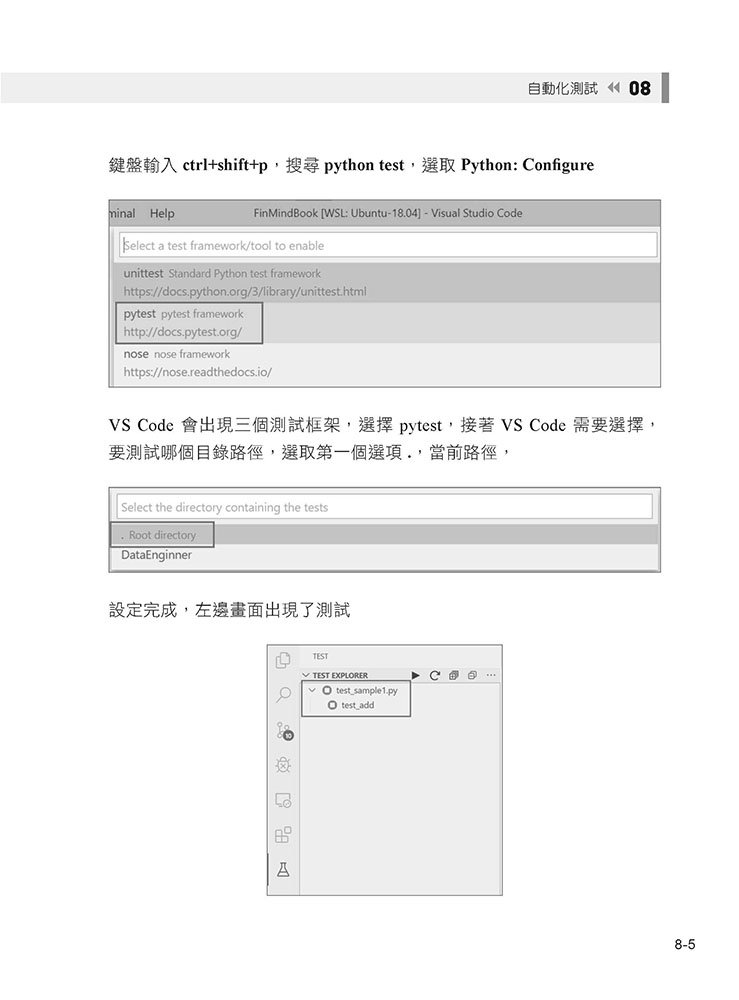

8.1 單元測試 Unit Test

8.1.1 什麼是單元測試 Unit Test ?

8.1.2 第一個測試

8.1.3 測試覆蓋率

8.1.4 爬蟲單元測試範例

8.1.5 API 單元測試範例

►09 CICD 持續性整合、佈署

9.1 什麼是 CICD ?

9.2 CI 持續性整合

9.3 GitLab-CI、以爬蟲專案為例

9.4 GitLab-CI,建立 Docker Image

9.4.1 GitLab-Runner

9.4.2 CICD 建立 Docker Image

9.5 GitLab-CI,佈署新版本

9.6 GitLab-CI、以 API 專案為例

9.6.1 Test - 測試

9.6.2 Build - 建立 Image

9.6.3 Deploy - 佈署

9.7 總結

▍第3 篇 API 產品上線

►10 API 服務網址

10.1 為什麼需要網址?

10.2 No-IP 免費的網址申請

10.3 Let's Encrypt 免費的 SSL 憑證

10.4 Traefik

10.5 API 結合 Traefik

10.6 總結

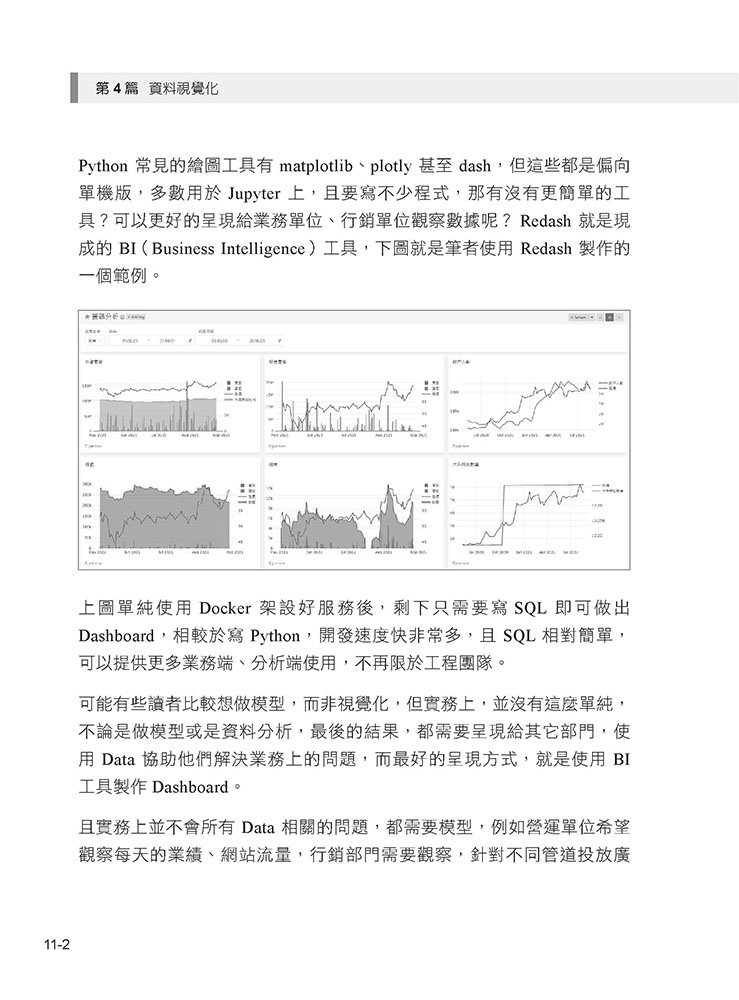

▍第4 篇 資料視覺化

►11 視覺化工具

11.1 什麼是視覺化?

11.2 Redash

11.3 Redash 帳號設定

11.4 資料庫連接

11.5 匯入資料

11.6 製作第一個圖表

11.7 第一個 Dashboard

11.8 設定下拉式選單

11.9 其他 BI 工具

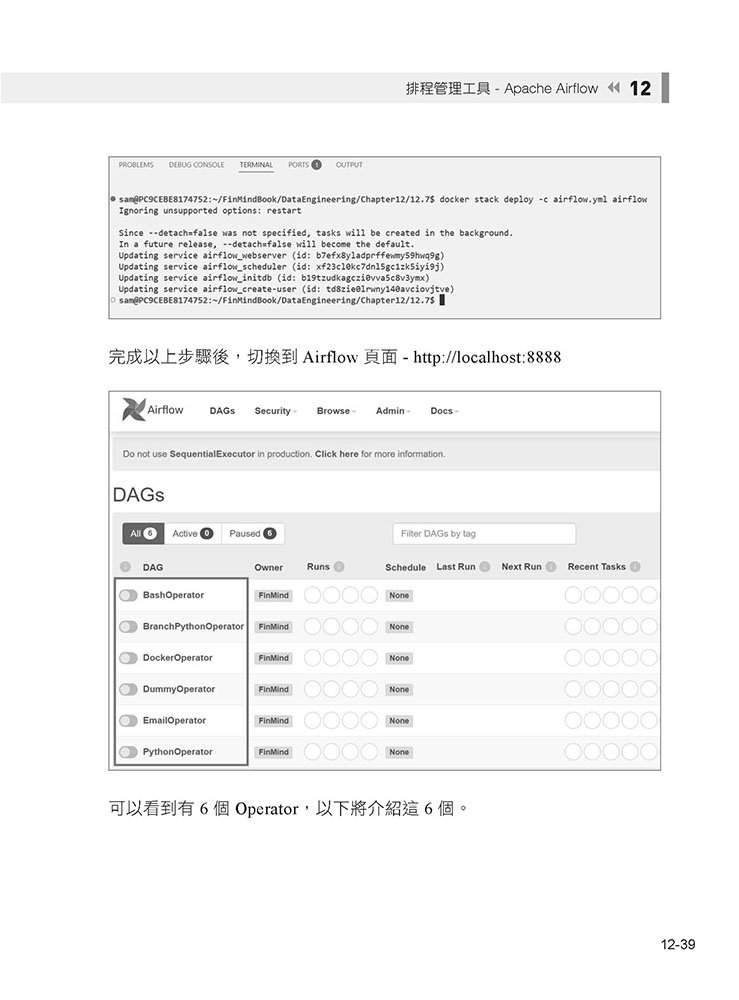

▍第5 篇 排程管理工具

►12 排程管理工具 - Apache Airflow

12.1 事前準備

12.2 什麼是排程管理工具?

12.3 為什麼選擇 Airflow ?

12.4 什麼是 Airflow ?

12.5 架設第一個 Airflow

12.5.1 為什麼使用 Docker 架設?

12.5.2 開始架設 Airflow

12.5.3 架構介紹

12.6 DAG 介紹

12.7 常見 Operator 介紹

12.7.1 BashOperator

12.7.2 PythonOperator

12.7.3 DummyOperator

12.7.4 BranchPythonOperator

12.7.5 DockerOperator

12.8 Airflow 結合爬蟲 - CeleryExecutor

12.8.1 架構介紹

12.8.2 架設 Airflow + CeleryExecutor

12.8.3 程式碼解析

12.9 結論

►13 Redis 介紹

13.1 麼是 Redis ?

13.2 使用Docker 架設Redis- 結合Celery

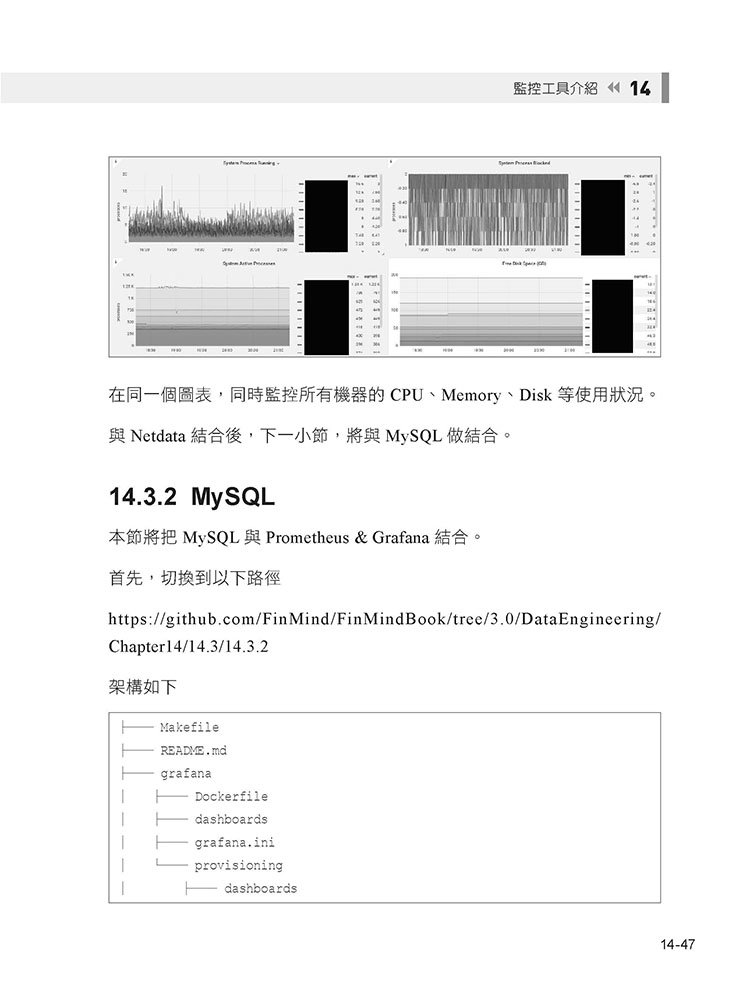

▍第6 篇 監控系統

►14 監控工具介紹

14.1 為什麼需要監控系統?

14.2 最知名的開源監控系統之一

14.2.1 Prometheus 介紹

14.2.2 Grafana 介紹

14.2.3 Netdata 介紹

14.2.4 如何尋找監控路徑 Metrics ?

14.3 架設個人化監控儀表板

14.3.1 Netdata

14.3.2 MySQL

14.3.3 RabbitMQ

14.3.4 Airflow

14.3.5 Traefik

14.4 總結

►15 結論